Tech-Guide

揭秘生成式AI:從「訓練」到「推論」,一窺其神奇運作原理

生成式人工智慧(generative AI)來勢洶洶,實用案例包括聊天機器人ChatGPT能撰寫文案與企劃案、Stable Diffusion等圖像生成工具能依指令產出栩栩如生的影像。事實上,想搞懂生成式AI不難,使用它比想像中還容易。技嘉科技在本篇《科技指南》中,為您解剖生成式AI背後「訓練」與「推論」兩個重要步驟,並為您推薦專為人工智慧開發所設計的技嘉解決方案,協助您成為AI世代的佼佼者。

雖然生成式AI不是真的拿畫筆的機器人,但它具有強大的能力與前瞻性,未來可能是人類最得力的工作夥伴。

人工智慧「訓練」的原理及最佳解決方案

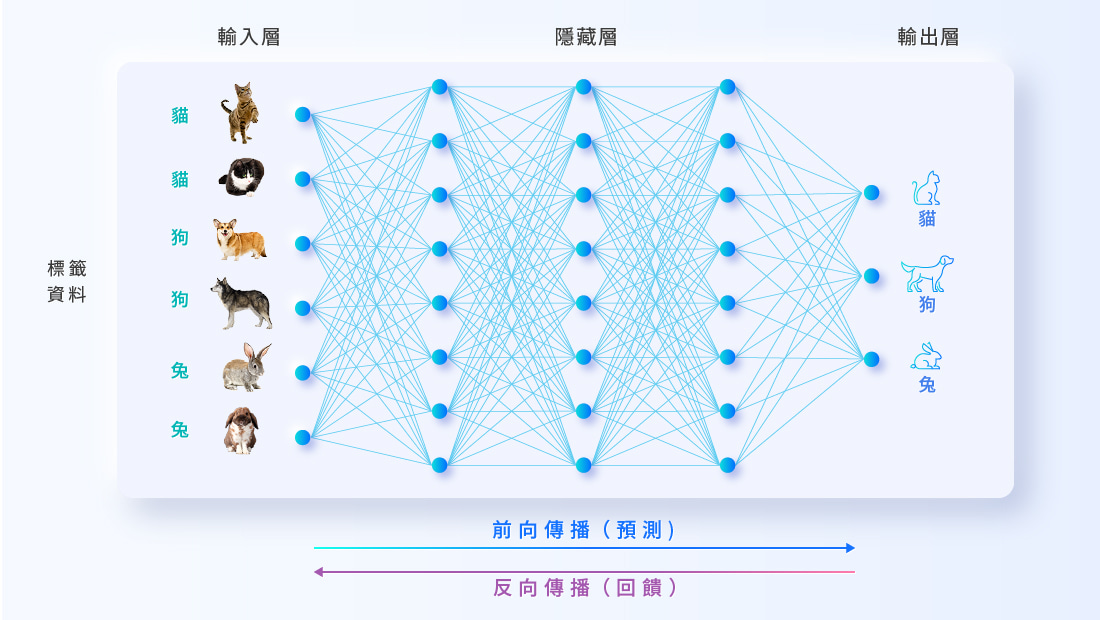

AI訓練階段,海量的標籤化資料灌入演算法中,讓人工智慧「練兵」。AI用這些資料練習猜測、調整參數,並反覆檢查輸出值的正確性,提升猜測的精確度。久而久之,AI「猜」力變得萬無一失,等於是學會了人類希望它辨識的資訊。

技嘉G593-SD0、G593-ZD2兩款伺服器,分別搭載第四代Intel® Xeon®或AMD EPYC™ 9004中央處理器,結合NVIDIA的HGX™ H100運算模組,是目前市面上最強大的AI超算平台之一,只需要佔用5U的機架空間,就能為您扮演人工智慧的開發先鋒。

人工智慧「推論」的原理及最佳解決方案

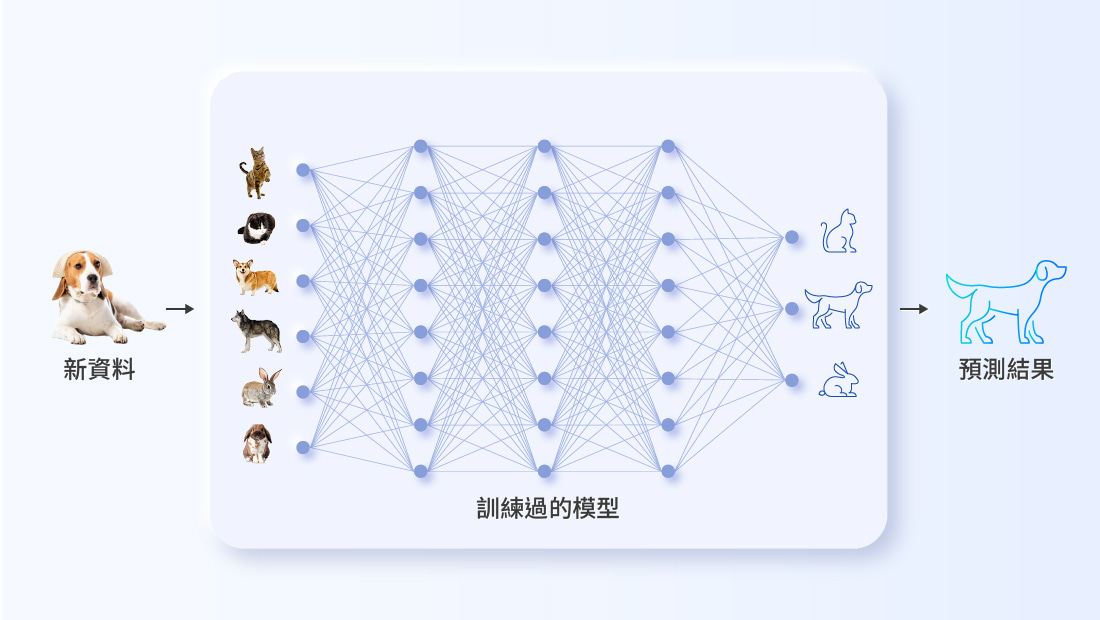

推論階段,人工智慧接收大量未標籤化的新資訊,將其與訓練過程中「練兵」使用的資料做比對,試圖預測正確的輸出值。無論AI猜對還是猜錯,結果一併儲存下來供下一次的訓練使用,持續加強AI模型的精確度。

技嘉G293-Z43提供超高密度推論加速卡配置,2U尺寸機身內可容納高達十六張AMD Alveo™ V70加速卡,給您超越業界標準的計算性能與低功耗、低延遲屬性。技嘉獨門的機殼構造與散熱設計,都是提升伺服器運算密度的關鍵技術。

想要掌握最新科技動向?馬上訂閱!

訂閱電子報

# Artificial Intelligence (AI)

# Machine learning (ML)

# Natural Language Processing (NLP)

# AI Training

# AI Inference

# Deep Learning (DL)

# Generative AI (GenAI)

# Supercomputing

# Computer Vision

# Cloud Computing

# Data Center

想要掌握最新科技動向?馬上訂閱!

訂閱電子報