Tech-Guide

如何透過GIGAPOD一站式服務,加速AI時代的全面革新

簡介

現代運算架構中的各種挑戰

最佳化的硬體配置

圖1 GIGABYTE G593 GPU伺服器

技嘉G593系列獨有的系統設計,具有以下優點:

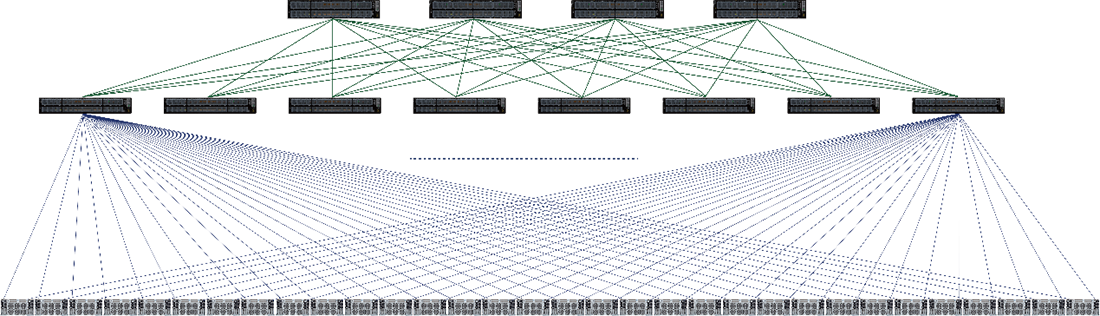

高擴展性的網路架構

圖2 GIGAPOD胖樹結構

完整機櫃層級AI解決方案

圖3 GIGAPOD液冷配置4 GPU Compute Racks

圖4 GIGAPOD氣冷配置

完善的部署流程

GIGAPOD 部署流程

結合AI創新的軟硬體整合

結論

想要掌握最新科技動向?馬上訂閱!

訂閱電子報

# Artificial Intelligence (AI)

# AI Training

# Machine Learning Operations (MLOps)

# Supercomputing

# PUE

想要掌握最新科技動向?馬上訂閱!

訂閱電子報